出品 | 搜狐科技

作者 | 梁昌均

“经典计算机体系结构存在着娘胎里带来的技术基因缺陷,这是网络空间会有这么多安全问题的原因。”在7月31日的ISC.AI2024数字安全峰会上,中国工程院院士、国家数字交换系统工程技术研究中心主任邬江兴表示。

他表示,AI应用系统安全可以分为非内生安全问题和内生安全问题,而其内生安全共性问题源于存储程序控制机理的自在性矛盾。“凡是包含存储程序控制构造数据元素的系统,如果不能杜绝软硬件代码设计的脆弱性,则自在性矛盾导致的内生安全问题不可避免。”

邬江兴强调,人工智能作为赋能技术,绝对不能走先发展后治理的道路,它会在网络安全、技术风险、社会影响等层面带来各种不同的风险。

不过,他认为AI应用系统的内生安全共性问题目前有解。网络安全中国学派提出了内生安全理论与拟态构造方法,有有利于构建一个安全可信的执行环境。

具体来看,需要打造基于构造设计的网络安全和功能安全。“内生安全的有效性是由它的构造决定,就像金刚石的硬度由它的分子结构决定。”邬江兴说。

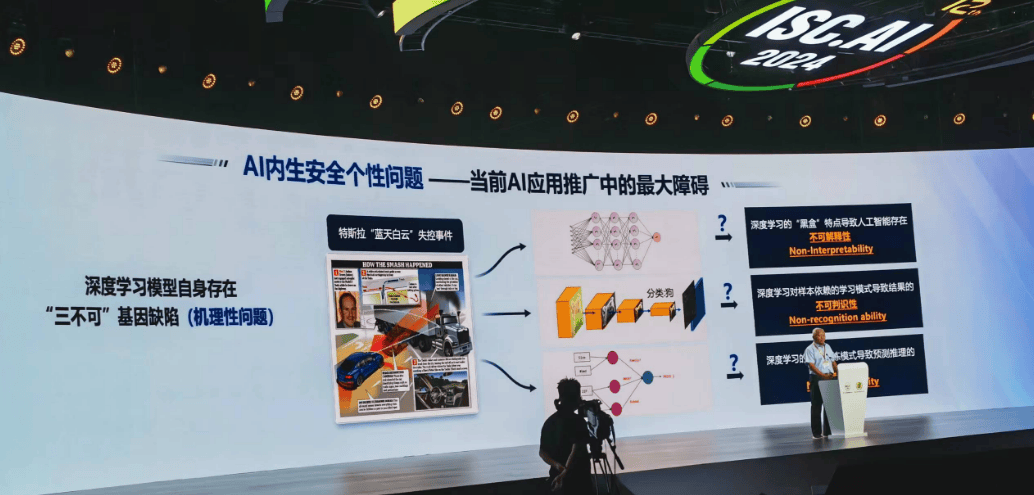

他表示,任何一个AI系统都是由计算机软件硬件组成,它所存在的问题跟现在网络空间存在的安全是一样的问题。这些问题要得到有效的解决,需要关注AI系统内生安全的个性问题。

“这是当前AI应用推广中的最大障碍,因为它存在着所谓的不可解释性、不可判识性、不可推论性,这是AI和大模型中特有的问题。”邬江兴提到。

那么,AI系统内生安全的个性问题如何解决?邬江兴表示,需要关注AI算法的多样性和特异性表达。

具体来说,AI算法模型对输入多样性敏感,稍许加点噪声,可能就识别不出来;AI算法模型对训练模式多样性敏感,训练方法的多样性比较大,可能会造成不同的判断;AI模型对训练数据多样性敏感,训练时间、顺序、尺度变化也会带来不同的结果。此外,它还对推理分析能力的多样性敏感,模型对同一任务的推理能力存在差异性。

“正好我们可以利用这种多样性,因此在安全的AI应用系统中引入多个算法模型很有必要,可以有效增加判识维度,为形成对齐奠定基础。”邬江兴表示,内生安全构造需要同时满足必要多样性定律和先对正确公理,即在多样性基础上还要跟人类价值观对齐。

他认为,基于这样的内生安全架构可以发现或纠正AI应用系统安全问题。“多样化是AI系统的必要安全技术,所以在这里我斗胆建议,不要相信任何一个模型,不能指望一个系统,而是应该采用多系统,这是保证安全最重要的方式之一。”

针对同一个目标,也应该可以采用差异化的网络算法。“比方用文心一言,再用360的模型,就会有模型生成多样化,这种多样化保证了表达的差异性,安全性也会高于单一的系统。”

“现在国内100多种模型出来,谁更安全,使用者很茫然。很多开发商明知产品存在安全问题,但仍将问题产品推向市场,用户怎么选,这是个大问题,所以当前AI应用系统出现安全责任和风险严重失衡的问题。”邬江兴说。

这导致了目前AI应用推进中面临的最大窘境——既不能机会主义地使用安全性尚不能确保的AI应用系统,又不能完美主义地追求绝对可行的AI应用系统。

邬江兴强调,内生安全范式应当是AI应用系统健康发展的基本遵循,凡是实用化AI应用系统都应该保证必要多样性定律和相对正确公理,要从思维视角、方法论、实践规范等方面落实,从而实现更安全的AI应用系统。